팹리스들 엔비디아 GPU 주도 속 NPU 틈새 공략…메모리 반도체 기업들도 LPDDR 기술 경쟁

#추론용에 적합한 NPU 개발 속도

NPU 팹리스 스타트업들의 움직임이 활발하다. SK텔레콤 자회사 사피온과 최근 합병한 리벨리온이 대표적이다. 리벨리온은 올해 NPU ‘아톰’을 양산한 데 이어 이르면 올해 말 대규모 언어모델(LLM)을 지원하는 차세대 NPU ‘리벨’을 내놓을 예정이다. 모빌린트·퓨리오사AI·딥엑스 등 국내 팹리스 스타트업도 NPU 양산에 속도를 내고 있다. 영국 그래프코어, 미국 세레브라스 등도 NPU 신제품을 잇달아 출시하고 있다.

글로벌 AI 반도체 시장의 90%는 엔비디아가 장악하고 있다. 엔비디아 GPU는 고용량 데이터 병렬 연산에 강점이 있다. 챗GPT 등 LLM 구동에 필수적이다. GPU 기반 AI 칩은 다양한 AI 서비스 구현이 가능해 범용성이 높다. 하지만 가격이 비싸고 전력소모가 커 효율이 떨어지는 단점이 있다. 최근 공급 부족으로 엔비디아 GPU 대기 시간이 길어지고 있다.

NPU 팹리스 기업들은 NPU가 GPU를 보완 내지 일부 대체할 수 있다고 보고 있다. NPU는 GPU보다 성능은 낮다. 하지만 가격이 GPU 10분의 1 수준으로 알려졌다. NPU는 설계 시점부터 특정 분야별로 특화되기 때문에 GPU보다 전력 효율이 높다. NPU를 개발 중인 국내 한 팹리스 관계자는 “추론용 시장에서는 AI 서비스나 제품을 내놓고 싶은 기업들은 전력·비용·스펙 등 전략에 따라 각 도메인에 맞는 특화된 칩이 필요하다”고 설명했다.

현재 NPU는 엔비디아 GPU처럼 AI 데이터센터(서버)용으로 개발되거나, 스마트폰·차량·PC 등 디바이스와 소규모 서버 등 엣지디바이스용으로 개발되고 있다. 삼성전자나 퀄컴 등 스마트폰용 AP 설계 능력을 보유한 기업들도 독자 개발한 NPU를 PC나 스마트폰에 탑재하기 시작했다. 모바일 기기가 자동으로 AI 연산을 할 수 있는 ‘온디바이스 AI’를 구현하기 위해서다. NPU 시장은 당장은 엣지디바이스용을 중심으로 성장이 점쳐진다.

#삼성전자, LPDDR 탑재한 마하-1 개발 중

다른 한편에서는 HBM 대신 LPDDR의 역할이 늘어날 것이란 전망이 나온다. LPDDR은 전력 소모를 최소화한 D램이다. 예컨대 퓨리오사AI가 올 4분기 출시할 엣지디바이스용 NPU ‘레니게이드S’에는 LPDDR이 탑재될 전망이다. 딥엑스의 NPU ‘DX-H1’ 등에는 LPDDR이 장착됐다. 권영화 세종대 경영전문대학원 겸임교수는 “LPDDR도 대역폭을 높이기 위해 층을 쌓고 있다. 그만큼 성능이 더 좋아질 수 있는 것”이라고 말했다.

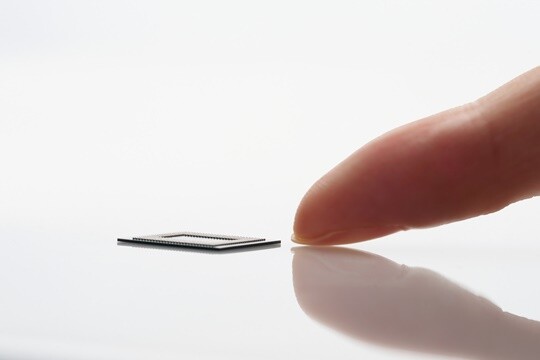

엔비디아에 공급할 HBM에 집중했던 메모리 반도체 기업들도 LPDDR 기술 경쟁에 한창이다. 지난 8월 삼성전자는 업계 최소 두께를 구현한 12나노(nm, 10억 분의 1m)급 LPDDR5X D램 12·16GB(기가바이트) 패키지 양산을 시작했다. 삼성전자는 LPDDR에 연산 기능을 더한 LPDDR5X-PIM도 내놓기로 했다. 지난해 11월 SK하이닉스는 초당 9.6Gb(기가바이트)로 데이터를 전송할 수 있는 LPDDR5T를 선보였다. SK하이닉스는 혁신적인 대역폭과 전력을 갖춘 LPDDR6도 개발 중이라 밝혔다.

다만 AI 반도체 시장 중 엣지디바이스와 달리 서버 시장에서는 당분간 큰 변화를 기대하기는 어렵다는 것이 중론이다. 김정호 카이스트 전기 및 전자공학과 교수는 “NPU와 LPDDR 조합은 특정 모델에만 써야 한다. 엣지디바이스용 시장은 좀 열리겠지만 당분간은 GPU와 HBM 조합이 큰 시장이 될 것 같다”라고 말했다. 반도체 업계 한 관계자는 “GPU와 HBM 조합이 메인으로 계속 갈 듯하다. NPU와 LPDDR 조합은 하나의 가성비 모델 느낌인 듯하다”라고 밝혔다.

김명선 기자 seon@ilyo.co.kr